리뷰 작성: 김장원 / 석사과정 (jangwonkim@postech.ac.kr)

1. Introduction

최근의 강화학습 알고리즘은 에이전트가 환경과의 직접적인 상호작용을 통해 복잡한 스킬들을 배울 수 있음을 증명하였다. 그러나 일련의 행동들이 연속적으로 이어진 상태로 오랜 시간 동안 진행되는 경우 (Temporally extended sequential decision making case), 에이전트는 현재 행동의 결과가 미래에 어떻게 영향을 미칠지 고려해야 하며, 긴 시간 동안 계획을 세우고 실행해야 한다. 본 논문에서는 이를 위해 플래닝을 활용한 GCRL 알고리즘을 제안한다.

당연하게도 플래닝이 성공적으로 동작하려면 정확한 모델이 요구된다. 전문 지식 등을 활용하여 모델을 직접 설계한다면 그 모델은 매우 정확하게 동작할 수 있지만, 만약 모델을 데이터를 통해 학습을 하게 된다면 정교한 모델을 얻기는 매우 어려울 수 있다. 특히 이미지와 같이 매우 높은 차원의 상태 (state)를 예측하는 모델을 만드는 것은 매우 어려운 작업이며 (Boots et al., 2014; Chiappa et al., 2017; Babaeizadeh et al., 2018), 먼 미래를 예측하는 것은 예측 에러가 누적되어 더더욱 어렵다 (Nagabandi et al., 2018).

이러한 모델 사용의 어려움을 극복하기 위해 본 논문에서는 planning over abstractions 라는 기법을 모델에 접목시킨다. 여기서 abstraction이란 상태 (주로 이미지와 같이 고차원인)을 간단하게 표현한 (simplified representation of state)것이다. 저자들은 이 abstraction을 활용하여 플래닝을 하는 것이 픽셀 이미지를 통으로 사용하여 플래닝을 하는 것보다 효율적이라고 주장한다. 여기서 모델은 추후에 설명하겠지만, 일반적인 model-based에서 사용하는 다음 상태를 예측하기 위한 forward model을 의미하는 것은 아니다. (여기서 말하는 모델이란 temporal difference model (Pong et al., 2018) 이다.)

Temporal abstractions을 활용하여 플래닝을 할 시 아주 정확한 디테일한 예측이 필요 없으며, 이는 좀 더 러프한 타임 스케일에서의 모델링을 가능하게 한다. 그리고 Temporal abstractions은 에이전트가 높은 레벨의 subgoal 상에서 플래닝을 하는 것이 아니라, 더 간단하게 표현된 압축 상태 (representation) 상에서 플래닝이 가능토록 해준다 (나중에 확인하겠지만, 압축 상태가 아니라면 플래닝이 매우 어려울 수 있다.). 둘 다 모델링과 플래닝을 쉽게 만들어 준다.

본 논문에서는 model-free RL 프레임워크가 이러한 abstractions을 제공하는 데 사용될 수 있다고 말한다. 언뜻 보면 model-free RL은 모델을 학습하는 것이 아니라 가치 함수 (value function)과 정책을 학습하기 때문에 이 말이 이상하게 느껴질 수 있다. 그러나 model-free RL은 설계 자체가 low-level (e.g., pixel-level)의 explicit한 예측을 필요로 하지 않고도 에이전트를 훈련시킬 수 있게 되어있다. 이러한 특징으로 인해 플래너 (planner)는 낮은 수준의 model-free 정책의 능력 (capability)에 대해 추론 할 수 있는 더 높은 수준의 추상화된 작업 수준에서 작동할 수 있으며, 이를 통해 플래너가 더 자유롭게 작업할 수 있게 된다. (원문: This leaves the planner free to operate at a higher level of abstraction, reasoning about the capabilities of low-level model-free policies.)

참고: 낮은 수준 (low-level) 상태란 가공되지 않은 raw image pixel을 의미하고, 높은 수준 (high-level) 상태란 매니폴드 상에서 압축되어 표현되는 상태 (representation)을 의미한다.

따라서 저자들은 model-free 플래닝 프레임워크를 제안한다. Temporal abstraction를 위해 저자들은 low-level goal-conditioned 정책을 학습하고, 그들의 가치 함수를 implicit 모델로서 사용한다. 이 가치 함수는 어떤 goal이 도달 가능할 법한지 알려주는 지표로 사용될 수 있다. 이 논문에서 제안하는 알고리즘에서 플래너는 goal-conditioned 가치 함수를 통해 목표 도달 가능성을 체크하면서 하위 목표 (sub-goal)들을 계획한다.

이제 우리의 목표는 플래너가 제공해주는 sub-goal들을 condition으로 가지는 정책을 학습해야 하는데, 높은 수준의 이미지 상태를 직접적으로 사용하여 학습하는 것은 쉽지 않다. 따라서 저자들은 이미지를 특정 하위 매니폴드 상에 맵핑해주는 인코더를 도입한다. 플래너는 이 매니폴드 형태로 sub-goal들을 표현한다. 그리고 학습된 goal-conditioned value-function는 이러한 sub-goal가 도달 가능한 지를 플래너에게 알려준다.

2. Related Work

GCRL은 널리 연구되고 있는 강화학습의 한 분야이다 (Kaelbling, 1993; Nair et al., 2018; Veeriah et al., 2018). GCRL 프레임워크는 목표 (goal)을 달성하도록 정책을 훈련시키는 데 큰 도움이 되지만, 종종 long-horizon 문제에서는 실패하기도 한다. 저자들은 이러한 long-horizon 문제를 해결하는 알고리즘을 제안한다.

모델 기반 강화학습 (Model-based RL)은 낮은 차원의 상태 공간에서 많은 연구가 되었다 (Punjani and Abbeel, 2015; Lenz et al., 2015; Nagabandi et al., 2018). 그러나 이미지와 같은 고차원에서 모델을 학습하여 미래를 예측하는 것은 훨씬 어려운 문제이다. 이러한 문제를 해결하기 위해 저자들은 실제 이미지 대신 매니폴드를 학습하여 이 매니폴드 상의 잠재 변수를 활용하여 플래닝을 하게 된다. 이렇게 저 차원의 잠재 공간을 학습하는 분야는 머신러닝 학계에서 많이 연구되었다 (Watter et al., 2015; Kurutach et al., 2018; Hafner et al., 2019). 본 논문에서는 단순히 잠재 공간을 하나의 상태 abstraction를 표현하기 위해 사용하는 것이 아니라 goal-conditioned 정책을 이용함으로써 long-horizon 문제를 해결하는 데 도움을 주는 temporal abstraction을 계획할 수 있게 한다는 것이 차이점이다.

(학습을 통해) 자동적으로 sub-goal을 생성한다는 아이디어는 계층적 강화학습 (hierarchical RL)과 유사하다. 보통 계층적 강화학습은 사전 지식을 활용하여 model-free RL와 goal-conditioned 정책을 결합하는 방법을 취한다. 본 논문에서는 보다 높은 수준에서 플래너라는 개념을 도입하여 새로운 작업을 더욱 유연하게 계획할 수 있으며, 계획의 구성적 구조에서 이점을 얻을 수 있다. (원문: By instead using a planner at the higher level, our method can flexibly plan to solve new tasks and benefit from the compositional structure of planning.)

저자들이 제안하는 방법은 temporal difference models (Pong et al., 2018) (TDMs)의 기본적인 개념을 사용한다. 그러나 본 논문의 저자들은 TDM을 implicit model로써 사용하면서도, 단순히 하나의 goal이 아닌 여러 subgoal을 계획하는 데 사용하게 된다. 아울러 본 논문에서 제안된 알고리즘은 저수준의 이미지 상태를 그대로 사용하는 것이 아니라, 매니폴드로 변환해서 상태를 사용하기 때문에 플래닝을 더욱 수월하게 해준다.

마지막으로 본 저자는 제안하는 알고리즘이 기존의 model-free RL이나 model-based RL과 다르다고 주장한다. 이는 직접적으로 모델을 사용하는 것이 아니라 플래닝의 abstraction으로써 model-free 정책을 사용하는 것이기 때문이다.

(TDM에 대한 철학을 이해하는 것이 본 논문을 더 깊게 이해는 데 도움을 준다. 따라서 TDM을 제안한 논문 Temporal difference models: model-free deep RL For model-based control. In International Conference on Learning Representations, Pong et al., 2018를 찾아보는 것을 추천한다.)

3. Background

본 논문은 finite-horizon, 튜플 $(\mathcal{S},\mathcal{A},\mathcal{G}, p, R, T_{max},p_0,p_g)$로 정의되는 goal-conditioned MDP를 기반으로 전개된다. 여기서 $\mathcal{S}$는 상태 공간을, $\mathcal{G}$은 목표 (goal)의 집합을, $\mathcal{A}$는 행동들의 집합을, $p(s_{t+1}|s_t,a_t)$는 시-불변 다이나믹스를, $R$은 리워드 함수를, $T_{max}$는 maximum horizon을, $p_0$은 초기 상태 분포를, 그리고 $p_g$는 goal 분포를 의미한다. GCRL의 목표는 기대 누적 보상의 합$\mathbb{E}\left[ \Sigma^{T_{max}}_{t=0}R(s_t,\textbf{g},t) \right]$, where $goal\sim p_g, a_t\sim\pi(a_t|s_t,\textbf{g},t),s{t+1}\sim p(s_{t+1}|s_t,a_t)$을 최대화 하는 정책 $\pi(a_t|s_t,\textbf{g},t)$를 찾는 것이다. 본 논문에서는 여기서 goal들의 집합과 상태 공간의 집합이 같은 경우 만을 다룬다 $(\mathcal{S}=\mathcal{G})$.

GCRL에서 사용되는 중요한 함수는 바로 goal-conditioned 가치 함수 (value function) $V^{\pi}$일 것이다. 본 논문에서 계속 사용될 goal-conditioned 가치 함수는 상태 $s$, 목표 $g$, 그리고 시간 $t$가 주어졌을 때 기대되는 미래 보상의 누적 이다. 이는 아래 식으로 표현할 수 있다.

$$ V^{\pi}(s,\textbf{g},t)=\mathbb{E}\left[ \Sigma^{T_{max}}_{t'=t}R(s_{t'},\textbf{g},t')|s_t=s,\pi \text{ is conditioned on }\textbf{g} \right]. $$

앞으로 $V^{\pi}$에서 정책 $\pi$에 대한 의존성을 생략하여 단순히 $V$로 깔끔하게 표기하겠다. 시간 의존성을 가지는 리워드 함수는 여러가지가 있지만, temporal difference models (TDMs)는 아래와 같은 리워드 함수를 사용하였다.

$$ \begin{align} R_{TDM}(s,\textbf{g},t)=-\delta(t=T_{max})d(s,\textbf{g}). \end{align} $$

여기서 $\delta$는 indicator 함수이고, $d$는 task에 따라 정의되는 거리 함수이다. 식 (1)의 리워드 함수 $R_{TDM}$은 에피소드가 끝났을 때 (혹은 한번의 rollout이 끝났을 때) 에이전트 (목표 $\textbf{g}$에 도달하려고 시도 중인)의 상태 $s$가 목표 $\textbf{g}$와 얼마나 가까운 지에 대한 값으로 해석할 수 있다. 본 논문에서는 이 TDM의 개념에다 상태 abstraction을 적용하는데, 이는 유효한 목표만을 탐색하는 것을 도와준다.

4. Planning with Goal-Conditioned Policies

이제 본격적으로 본 논문에서 제안하는 알고리즘에 대한 내용을 서술할 것이다. 앞서 말했듯이 이미지와 같은 높은 차원의 상태를 가지는 임의의 long-horizon goal reaching tasks에 대해 잘 동작하는 model을 만드는 것이 이 알고리즘의 핵심이다.

물론 model-free 기반의 여러 GCRL 알고리즘 (예를 들어 HER)들도 이러한 문제 (long-horizon goal reaching tasks)를 해결할 수 있다. 하지만 더욱 시간적으로 연관을 가지는 긴 문제 (more temporally extended problem)에서는 model-free GCRL 알고리즘이 효율적으로 에이전트를 학습하기 어려움을 저자들은 실험에서 보였다.

제안된 알고리즘에는 goal-conditioned 정책은 주어진 subgoal을 달성하도록 학습이된다. 또한 플래너 (planner)는 하나의 long-horizon goal (앞으로 true goal이라 부르겠음.)을 $K$개의 sub-goals로 나누어주도록 학습된다:

$$ Planner:\textbf{g}_{true}\to(\textbf{g}_{1},\textbf{g}_{2},...,\textbf{g}_{K}) $$

이 후 정책은 정해진 시간 구간 동안 sub-goal을 추종하도록 사용된다. 예를 들어 미리 정해진 에피소드의 길이를 $T_{max}$라고 한다면 이를 K+1개 (K가 아니라)의 시간 간격으로 쪼갠다. 이 K+1개의 쪼개진 시간 간격을 각각 $t_1,t_2,...,t_K,t_{K+1}$라고 한다면, 에이전트는 맨 처음 sub-goal $\textbf{g}_1$을 처음 $t_1$동안 추종하고, sub-goal $\textbf{g}_2$을 그 다음 $t_2$동안 추종하고, 그리고 계속해서 sub-goal $\textbf{g}_K$는 $t_K$동안 추종하게 된다. 그리고 마지막 $t_{K+1}$시간 동안은 true goal $\textbf{g}_{true}$를 추종하게 된다. 이 과정을 아래 표에 정리하였다.

시간 간격에 대한 특별한 제한은 없지만, 제안된 알고리즘에서는 정해진 $T_{max}$를 균일하게 $K+1$등분하여 시간 간격을 정해주었다. 여기서 맨 마지막 시간 간격 $t_{K+1}$에는 반드시 true goal인 $\textbf{g}_{true}$에 대응됨에 주목하라. 이는 우리의 정책이 결국 true goal 최종적으로 추종하게 하기 위함이다.

만약 우리가 이 sub-goals들을 적절하게 정할 수 있다면, long-horizon 하며 temporally extended한 task를 효과적으로 풀 수 있을 것이다. 여기서 sub-goals들을 ‘적절’하게 정한다는 의미는, sub-goal이 현재 상태로부터 충분히 도달 가능해야하며, 이 일련의 sub-goal들이 최종적으로 true goal 도달하도록 구성되어야 한다는 말이다. 이 핵심 아이디어는 아래 figure 1에 자세히 묘사되어있다.

4.1. Planning over Subgoals

이 장에서는 앞에서 언급한 ‘적절’한 sub-goals들을 만들기 위한 방법을 소개한다. 먼저 현재 상태로부터 도달 가능한 sub-goal들을 어떻게 파악할 수 있을 지부터 생각해보자. 가장 자연스러운 방법은 아마 goal-conditioned 가치 함수를 이용하는 것이다. 직관적으로 가치 함수를 크게 만드는 sub-goal이 그렇지 않은 sub-goal보다 더 도달 가능한 sub-goal일 것이다. 예를 들어 보상으로 $R_{TDM}$을 사용할 때, 어떤 정책이 $t$시간 후에 목표 $\textbf{g}$에 도달한다면 $V(\textbf{s},\textbf{g},t)=0$ 이며 도달하지 못한다면 가치 함수가 0보다 작은 값일 것이다.

본 논문에서도 이러한 방식으로 도달 가능한 sub-goal들을 파악하게 된다. 또한 최종 sub-goal을 true goal로 사용하도록 제한을 건다면 결국 일련의 sub-goal들을 거쳐 우리가 원하는 최종 true-goal에 도달할 수 있을 것이다.

이제 적절한 sub-goals들을 만들기 위한 작전을 세웠으니, 이 작전을 성공적으로 달성할 수 있는 특별한 loss를 생각해보자. 저자들은 이 loss를 만들기 위해 아래의 feasibility vector라는 벡터를 정의하였다.

$$ \text{feasibility vector: }\vec{\textbf{V}}(\textbf{s},\textbf{g}_{1:K},t{1:K+1},\textbf{g}_{true})=\begin{bmatrix} V(\textbf{s},\textbf{g}_{1},t_{1}) \\ V(\textbf{g}_{1},\textbf{g}_{2},t_{2}) \\ \vdots \\ V(\textbf{g}_{K-1},\textbf{g}_{K},t_{K}) \\ V(\textbf{g}_K,\textbf{g}_{true},t_{K+1}) \end{bmatrix} . $$

Feasibility vector의 각각의 원소 $V$가 0에 가깝다면 에이전트가 현재 상태에서 주어진 sub-goal을 주어진 시간 간격동안 충분히 갈 수 있음을 의미한다. 반대로 0에서 멀어지면 도달 가능성이 적다는 뜻이다. 즉, feasibility vector는 sub-goal들의 구성 플랜이 얼마나 적절한 지에 대한 척도를 제공해준다. 따라서 플래너는 이 feasibility vector의 norm 값을 최대한 0에 가깝게 만들도록 sub-goals들을 플래닝하면 된다. 이는 자연스럽게 아래와 같은 loss $\mathcal{L}$을 세울 수 있도록 만든다:

$$ \begin{align}\mathcal{L}=|| \vec{\textbf{V}}(\textbf{s},\textbf{g}_{1:K}, t_{1:K+1},\textbf{g}) ||_p).\end{align} $$

앞으로 이 loss를 최소화하는 sub-goals들을 생성하여 플래닝에 이용할 것이다. 이제 적절한 sub-goal들을 플래닝하기 위한 loss를 세웠으니, 이를 이미지와 같은 고차원 상태에서 활용하기 위한 방안을 생각해보자.

4.2 Optimizing over Images

식 (2)를 이미지와 같이 고차원 상태 공간을 가지는 환경에서 바로 적용하는 것은 쉽지 않다. 왜냐하면 이미지의 크기가 64x64 이고 3개의 sub-goal만 플래닝한다고 하여도 $\textbf{g}_{1:3}$의 차원은 무려 12288차원이나 된다. 또한 이렇게 큰 공간에서 feasible한 이미지를 선택하는 것도 쉽지 않다. 이렇게 큰 공간을 해집으면서 식 (2)를 어떻게 최소화 할 것인가..?! 대부분의 상태는 의미없는 노이즈에 불과할 것이다. (모래사장에서 바늘 찾기…) 따라서 이미지와 같이 고차원 상태 공간에서는 플래닝을 어렵게 만든다.

따라서 저자들은 고차원 상태 공간을 저차원의 잠재공간으로 mapping하고, 이 잠재공간을 이용하여 플래닝을 하는 방법을 제안한다. 이 매니폴드 공간을 학습하기 위해 저자들은 variational-autoencoder (VAE) (Kingma and Welling, 2014)를 이용한다. VAE는 환경에서 랜덤하게 샘플링된 상태를 가지고 학습하게 된다.

VAE는 인코더 $q_{\phi}(\textbf{z}|\textbf{s})$와 디코더 $p_{\theta}(\textbf{s}|\textbf{z})$로 구성되는데, 인코더를 통해 고차원 상태 공간 $s\in \mathcal{S}$을 저차원 상태 공간 $\textbf{z}\in \mathcal{Z}$으로 mapping 할 수 있게 된다. 이렇게 저차원의 공간 $\mathcal{Z}$상을 활용한다면 앞서 언급한 문제들을 회피할 수 있다.

저자들은 VAE를 학습시킬 때 Gaussian 분포를 잠재 공간의 prior로 사용하였다. 이는 임의로 정한것이지만, (Dai and Wipf, 2019)는 Gaussian prior를 사용하였을 시 언제나 true manifold를 복구할 수 있음을 증명하였으므로 충분히 매력적인 prior라고 볼 수 있다. 아래의 Figure 2는 VAE를 활용하여 고성한 잠재공간을 보여주는데, 대부분의 feasible한 이미지들이 한 곳에 몰려있음을 확인할 수 있다.

이제 이 저차원의 잠재공간을 활용하여 식 (2)의 loss를 재구성해보자. $p$를 잠재공간의 prior이라고 한다면, 저자들은 식 (2)의 loss를 아래와 같이 재구성하였다.

$$ \begin{align} \mathcal{L}_{LEAP}(\textbf{z}_{1:K})=|| \vec{\text{V}}(\textbf{s},\textbf{z}_{1:K},t_{1:K+1},\textbf{g}_{true}) ||{p}-\lambda \Sigma^{K}_{k=1}\log p(\textbf{z}_k). \end{align} $$

여기서

$$ \vec{\textbf{V}}(\textbf{s},\textbf{z}_{1:K},t_{1:K+1},\textbf{g}_{true})=\begin{bmatrix} V(\textbf{s},\psi(\textbf{z}_{1}),t_{1}) \\ V(\psi(\textbf{z}_{1}),\psi(\textbf{z}_{2}),t_{2}) \\ \vdots \\ V(\psi(\textbf{z}_{K-1}),\psi(\textbf{z}_{K}),t_{K}) \\ V(\psi(\textbf{z}_K),\textbf{g}_{true},t_{K+1}) \end{bmatrix}, $$

그리고

$$ \psi(\textbf{z})=argmax_{\textbf{g}'}p_{\theta}(\textbf{g}'|\textbf{z}). $$

새롭게 구성된 loss, $\mathcal{L}_{LEAP}$는 잠재 변수 $\textbf{z}$ 가 놓여있는 공간 $\mathcal{Z}$를 조사하면서 최소화하게 된다. 잠재 변수 $\textbf{z}$를 원래 상태 공간에서 표현되는 sub-goal로 변환하기 위해서는 디코더 $p_{\theta}$를 활용하게 된다. 잠재 변수로부터 변환된 sub-goal을 $\psi(\textbf{z})$라고 한다면, 이 sub-goal은 디코더에 MLE를 취함으로써 얻어진다:

$$ \psi(\textbf{z})=\text{MLE of }p_{\theta}=argmax_{\textbf{g}'}p_{\theta}(\textbf{g}'|\textbf{z}) $$

MLE 값은 디코더의 평균 값을 이용하게 되고, closed-form 형태로 계산되어질 수 있다. 아울러 $\mathcal{L}_{LEAP}$는 $\lambda \Sigma^{K}_{k=1}\log p(\textbf{z}_k)$라는 항을 추가적으로 가지 는 것을 볼 수 있는데, 이는 잠재 변수가 prior에서 많이 벗어나는 것을 방지하기 위한 항이다. 그리고 $\lambda$는 이 항의 중요성을 컨트롤하기 위한 하이퍼-파라미터이다. 아울러 feasibility vector의 어떠한 norm 값을 사용하여 최소화하든 상관없지만, 저자들은 maximum-norm이 일반적으로 좋은 성능을 보여주었다고 말한다.

4.3 Goal-Conditioned Reinforcement Learning

우리가 지금까지 줄곧 사용한 feasibility vector의 원소인 goal-conditioned 가치함수, $V(\textbf{s},\textbf{g},t)$는 TDM을 이용하여 학습하게 된다. TDM을 제안한 오리지널 논문 (Pong et al., 2018)에서는 $V$함수 대신 $Q$함수를 학습하는데, 본 논문에서는 DDPG, TD3에 사용되는 정책처럼 결정론적 정책을 활용하여 $V$함수를 평가하게 된다. 즉,

$$ V(\textbf{s},\textbf{g},t)=Q(\textbf{s},\textbf{a},\textbf{g},t)|_{\textbf{a}=\pi(\textbf{s},\textbf{g},t)}. $$

또한 저자들은 VAE서 학습한 인코더를 정책과 가치 함수에 적용한다. 즉, pretrained된 VAE의 인코더를 통해 representing feature를 뽑고 fully connected 레이어를 추가하여 정책과 가치 함수를 학습하게 함으로써 샘플 효율성을 높였다.

4.4 Summary of Latent Embeddings for Abstracted Planning

지금까지 설명한 방법을 저자들은 Latent Embeddings for Abstracted Planning (LEAP)라고 이름 붙였다. 아래는 이 알고리즘에 대한 pseudo code이다.

이 pseudo code를 풀어서 설명하면 다음과 같다.

- 먼저 VAE를 학습한다. (초기 단계에서는 랜덤하게 샘플들을 추출한다.)

- TDM 정책과 가치 함수를 학습한다.

- 식 (3)을 최소화하도록 sub-goals을 설정한다. 그리고 각각의 sub-goals을 수행하는 시간 간격동안 각각의 sub-goal을 인풋으로 가지는 goal-conditioned 정책을 통해 다음 action을 고른다.

(저자들은 시간 간격을 균일하게 나누었다 ($T_{max}/(K+1)$). 이 시간 간격을 단순히 균일하게 사용하지 않고 최적화하는 방법을 연구하는 것도 흥미로운 주제가 될 것이다.)

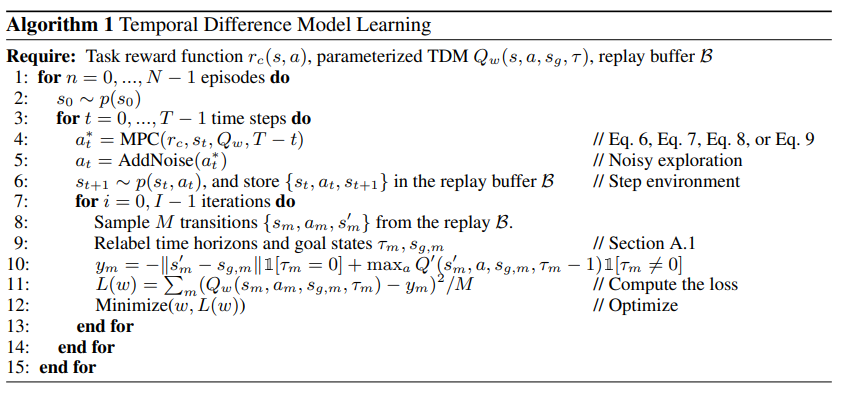

TDM 정책 및 가치 함수을 학습하는 방법은 아래와 같다 (Pong et al., 2018).

TDM 학습의 자세한 내용은 Pong et al., 2018 참고.

5. Experiments

LEAP의 효율성을 입증하기 위해 저자들은 여러 model-free 방법과 model-based 방법을 베이스라인으로 하여 LEAP와의 성능 비교를 진행하였다. 실험에는 vision-based task와 non-vision-based task 둘 다 포함한다.

5.1 Vision-based Comparison and Results

먼저 저자들은 Vision-based 환경에서의 성능 테스트를 위해 다음과 같은 두 task를 설정하였다.

1. 2D-Navigation 2D-Navigation은 아래 그림과 같이 U-shaped wall가 존재하는 공간에서 주어진 목적지를 찾아가는 task이다. 상태로는 환경의 top뷰가 사용된다.

2. Push and Reach 환경

Push and Reach는 로봇 팔을 컨트롤하는 task이다. 이 task는 두 가지 과제가 있는데, 첫 번째는 puck을 특정 타겟 목적지에 옮기는 것이고, 두 번째는 로봇 팔의 끝 부분을 또 다른 타겟 목적지에 옮기는 것이다.

모든 task 실험에 대해 $T_{max}=100$을 적용하였고, $\mathcal{L}_{LEAP}$를 최소화하기 위해 CEM을 사용하였다. sub-goal의 수 $K$는 3으로 정하였고, 따라서 각 sub-goal마다 25 시간 간격을 가진다. 저자들은 LEAP를 model-free TDMs과 비교하였고 $T{max}=25$를 사용한 TDM과 $T_{max}=100$을 TDM을 각각 TDM-25, TDM-100으로 명명하였다. 또 다른 model-free 베이스라인으로 reinforcement learning with imagined goal (RIG) (Nair et al., 2018)과 hindsight experiment replay (HER) (Andrychowicz et al., 2017)를 사용하였다. model-based 베이스라인으로는 probabilistic ensembles with trajectory sampling (PETS) (Chua et al., 2018)를 이용하였고, 이 알고리즘에는 ground-truth low-dimensional state representation을 이용하였고 PETS, state라고 명명하였다.

아래는 LEAP와 베이스라인들과의 성능 그래프를 보여준다.

실험 결과 LEAP가 다른 베이스라인과 비교하여 더 높은 샘플효율성을 보임을 확인할 수 있었다. 특히 Push and Reach 환경에서는 최종 성능이 다른 베이스라인에 비해 높음을 보인다. 한편 LEAP에서 사용되는 잠재 공간에 대한 시각화를 통해 디코더, 가치 함수를 살펴본 결과는 아래와 같다.

Figure 4 를 보면 sub-goal들이 long-horizon 문제를 풀기 위해 매우 적절히 생성되었음을 확인할 수 있다. 또한 2D-Navigation task 환경에서 현재 에이전트의 위치의 goal-conditioned 가치 함수를 살펴보면 벽 너머 목적지의 값은 매우 낮은 것을 확인할 수 있다. 또한 남은 horizon 타임 스텝 t가 길어질 수록 더 많은 목적지가 feasible 해짐을 확인할 수 있다.

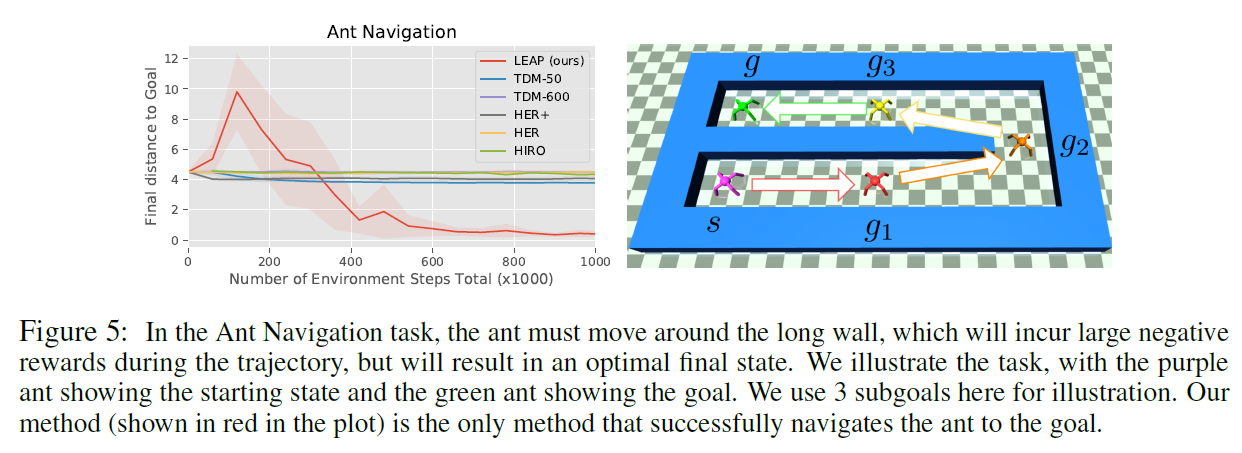

5.2 Planning in Non-Vision-based Environment with Unknown State Spaces

저자들은 LEAP를 vision-based task 뿐만 아니라 non-vision-based task에도 적용하였다. 실험에 사용한 task는 Ant Navigation이라는 환경이다. 여기서 상태는 에이전트의 joint angles, joint velocity, 그리고 center of mass를 포함한다. 비록 이 상태는 이미지보다 훨씬 컴팩트하지만, feasible한 상태값들의 조합은 이미지와 마찬가지로 한정되어있을 것이고, 따라서 어떤 매니폴드에 놓여져있을 것이다. 결국 이 task에도 잠재 공간의 개념을 도입하는 것이 도움이 될 것이다.

Ant Navigation 환경에서는 훨씬 큰 $T_{max}=600$을 부여하였다. 그리고 $\mathcal{L}_{LEAP}$는 $K=11$개의 sub-goal에 대해 최적화를 진행한다 (최적화 방법은 이미지와 마찬가지로 CEM). 비교에 사용한 베이스라인은 TDM-50, TDM-600 그리고 HER에 RIG와 같은 리워드와 relabeling 방법을 적용한 HER+를 사용하였다. 또한 계층적 강화학습 알고리즘의 하나인 hierarchical reinforcement learning with off-policy correction (HIRO) (Nachum et al., 2018)를 베이스라인으로 추가하였다. 실험 결과는 아래와 같다.

위 그래프는 오직 저자들이 제안한 LEAP만 task를 성공할 수 있었음을 보여준다.

5.3 Ablation Study

저자들은 다음을 조사하기 위해 ablation study를 진행하였다.

- VAE를 통해 잠재공간을 뽑아내어 플래닝을 하는 것이 그렇지 않았을 때와 비교하였을 때 얼마나 학습에 영향을 미치는지?

- VAE의 인코더를 정책과 가치 함수에 재사용하는 것이 얼마나 샘플 효율성을 증가시키는지?

- $\mathcal{L}_{LEAP}$의 최적화 기법들, $\lambda$의 민감성, 그리고 norm의 종류에 따른 성능 변화는 어떠한지?

Figure 6을 통해 잠재 공간을 사용하는 것과 VAE의 인코더를 정책과 가치 함수를 학습하기 위해 재사용하는 방법 모두 샘플 효율성 및 성능 향상에 큰 도움을 줌을 확인할 수 있다. 또 하나의 흥미로운 점은 잠재 공간을 사용하지 않았을 때는 feasibility vector의 norm을 최소화하는 sub-goal들이 실제로 노이즈와 같이 의미 없는 이미지였던 경우가 존재한다는 점이다. 이런 측면에서 잠재 공간의 활용은 feasible한 sub-goal을 만드는 데 큰 역할을 할 수 있다고 볼 수 있다.

또한 norm의 종류, $\mathcal{L}_{LEAP}$의 최적화 기법, 그리고 $\lambda$의 민감성에 관한 ablation 스터디 결과는 아래와 같다.

6. Summary

이 논문에서는 goal-conditioned 정책과 가치 함수를 사용하여 , 긴 시간 동안 시간적으로 연관되어있어 추론이 필요한 long-horizon task를 풀기 위해 LEAP라는 새로운 알고리즘을 제안한다. LEAP는 TDM 가치 함수와 feasibility vector 개념을 도입하여 적절한 sub-goal들을 플래닝한다. 또한 VAE를 통한 매니폴드 러닝을 통해 고차원의 이미지를 저차원의 잠재공간에 맵핑시켜, 이 잠재공간을 활용하여 플래닝을 하게된다. 두 Vision-based 와 non-vision-based 환경에서 LEAP는 다른 베이스라인 알고리즘보다 더 높은 샘플 효율성을 및 최종 성능을 보였다.

References

[1] Boots, Byron, Arunkumar Byravan, and Dieter Fox. "Learning predictive models of a depth camera & manipulator from raw execution traces." 2014 IEEE International Conference on Robotics and Automation (ICRA) . IEEE, 2014.

[2] Silvia Chiappa, Sébastien Racaniere, Daan Wierstra, and Shakir Mohamed. Recurrent environment simulators. In International Conference on Learning Representations, 2017.

[3] Mohammad Babaeizadeh, Chelsea Finn, Dumitru Erhan, Roy H Campbell, and Sergey Levine. Stochastic variational video prediction. In International Conference on Learning Representations, 2018.

[4] Anusha Nagabandi, Gregory Kahn, Ronald S Fearing, and Sergey Levine. Neural network dynamics for model-based deep reinforcement learning with model-free fine-tuning. In IEEE International Conference on Robotics and Automation, 2018.

[5] Leslie Pack Kaelbling. Learning to achieve goals. In International Joint Conference on Artificial Intelligence (IJCAI), volume vol.2, 1993.

[6] Ashvin Nair, Vitchyr Pong, Murtaza Dalal, Shikhar Bahl, Steven Lin, and Sergey Levine. Visual reinforcement learning with imagined goals. In Advances in Neural Information Processing Systems, 2018.

[7] Vivek Veeriah, Junhyuk Oh, and Satinder Singh. Many-goals reinforcement learning. arXiv preprint arXiv:1806.09605, 2018.

[8] Ali Punjani and Pieter Abbeel. Deep learning helicopter dynamics models. In IEEE International Conference on Robotics and Automation, 2015.

[9] Ian Lenz, Ross Knepper, and Ashutosh Saxena. DeepMPC: learning deep latent features for model predictive control. In Robotics: Science and Systems (RSS), 2015.

[10] Anusha Nagabandi, Gregory Kahn, Ronald S Fearing, and Sergey Levine. Neural network dynamics for model-based deep reinforcement learning with model-free fine-tuning. In IEEE International Conference on Robotics and Automation, 2018.

[11] Manuel Watter, Jost Tobias Springenberg, Joschka Boedecker, and Martin Riedmiller. Embed to control: a locally linear latent dynamics model for control from raw images. In Advances in Neural Information Processing Systems, 2015.

[12] Thanard Kurutach, Aviv Tamar, Ge Yang, Stuart J Russell, and Pieter Abbeel. Learning plannable representations with causal infogan. In Advances in Neural Information Processing Systems, 2018.

[13] Danijar Hafner, Timothy Lillicrap, Ian Fischer, Ruben Villegas, David Ha, Honglak Lee, and James Davidson. Learning latent dynamics for planning from pixels. In International Conference on Machine Learning, 2019.

[14] Vitchyr Pong, Shixiang Gu, Murtaza Dalal, and Sergey Levine. Temporal difference models: model-free deep rl For model-based control. In International Conference on Learning Representations, 2018.

[15] Kingma, D. P. & Welling, M. (2014). Auto-Encoding Variational Bayes. In International Conference on Learning Representations, ICLR 2014.

[16] Bin Dai and David Wipf. Diagnosing and enhancing vae models. In International Conference on Learning Representations, 2019.

[17] Ashvin Nair, Vitchyr Pong, Murtaza Dalal, Shikhar Bahl, Steven Lin, and Sergey Levine. Visual reinforcement learning with imagined goals. In Advances in Neural Information Processing Systems, 2018.

[18] Marcin Andrychowicz, Filip Wolski, Alex Ray, Jonas Schneider, Rachel Fong, Peter Welinder, Bob Mcgrew, Josh Tobin, Pieter Abbeel, and Wojciech Zaremba. Hindsight experience replay. In Advances in Neural Information Processing Systems, 2017.

[19] Kurtland Chua, Roberto Calandra, Rowan McAllister, and Sergey Levine. Deep reinforcement learning in a handful of trials using probabilistic dynamics models. In Advances in Neural Information Processing Systems, 2018.

[20] Ofir Nachum, Google Brain, Shane Gu, Honglak Lee, and Sergey Levine. Data-efficient hierarchical reinforcement learning. In Advances in Neural Information Processing Systems, 2018.